در حالی که هوش مصنوعی (AI) در سالهای اخیر شاهد پیشرفتهای قابل توجهی بوده است، چالش جدیدی در مصرف رو به رشد تامین انرژی برای کارکرد و پردازش هوش مصنوعی وجود دارد. در این میان درک نیازهای انرژی برای تامین مصرف دیتاسنتر های هوش مصنوعی و پیامدهای آن بر استفاده از منابع انرژی برای متخصصان برق و همچنین برق اضطراری ضروری است.

در مورد تامین انرژی برای کارکرد هوش مصنوعی علاوه بر افزایش تقاضا برای انرژی بصورت مستقیم، تامین سرمایش برای دیتاسنتر و همچنین زیرساخت مناسب برای سرور هایی که شرکت های هوش مصنوعی از آن استفاده می کنند نیز وجود دارد که نگرانی هایی جدیدی را در مورد تامین انرژی مورد نیاز این تاسیسات و همچنین اثرات زیست محیطی این افزایش یکباره تقاضای انرژی بوجود می آورد.

در واقع هوش مصنوعی یا AI که یکی از دردسترس ترین نمونه های آن CHATGPT که توسط شرکت OPENAI ساخته شده است می باشد، چشم انداز تجزیه و تحلیل اطلاعات و فرآیندهای تصمیم گیری، جستجو و نوشتن را به یکباره تغییر داد. نیاز روزافزون به استفاده از هوش مصنوعی در زندگی روزمره مردم در سراسر جهان و یا کسب و کارها و صنایع مختلف تأثیر نامطلوبی بر میزان مصرف انرژی گذاشته است. با افزایش اندازه و پیچیدگی مدلهای هوش مصنوعی، آنها به منابع محاسباتی قابل توجهی نیاز دارند که هر روز بیشتر می شود و در نتیجه انرژی بالاتری مصرف خواهند کرد.

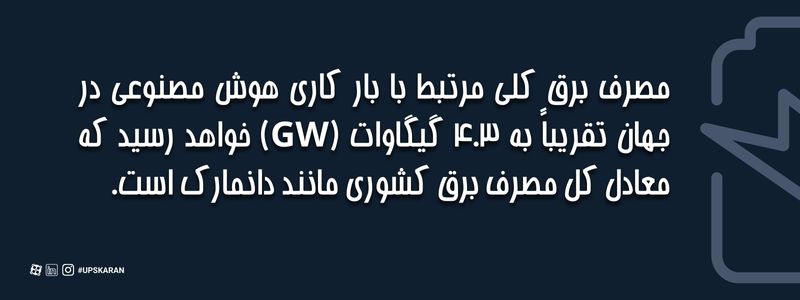

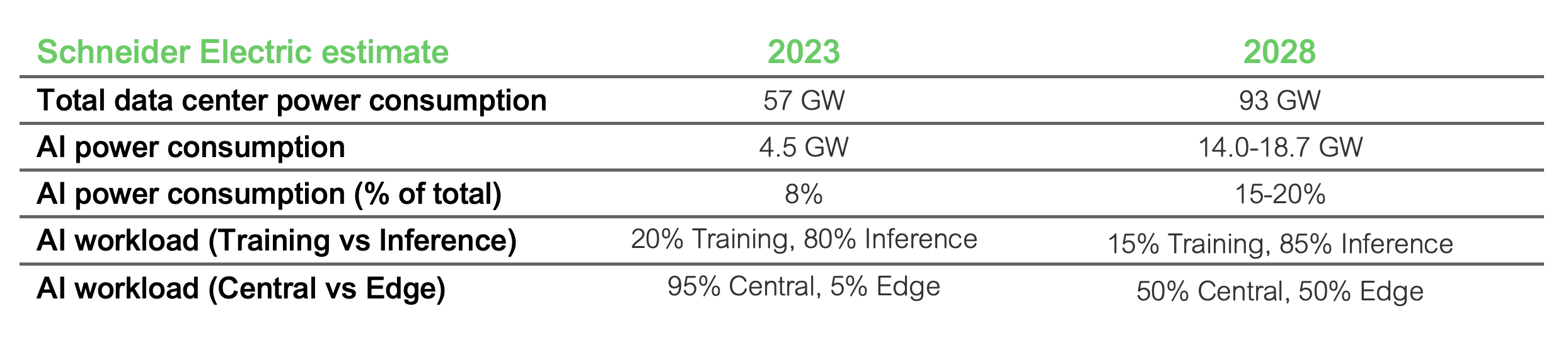

اشنایدر الکتریک در گزارشی که در سایت این شرکت منتشر شده پیشبینی میکند که مصرف برق کلی مرتبط با بار کاری هوش مصنوعی تقریباً به 4.3 گیگاوات (GW) خواهد رسید که معادل کل مصرف برق کشوری مانند دانمارک است. این مقایسه نیاز انرژی قابل توجه فناوری های هوش مصنوعی را برای خدمت به تقاضای رو به رشد برای راه حل های این فناوری جدید نشان می دهد.

از سال 2023، برآورد اشنایدر الکتریک نشان می دهد که 95 درصد از حجم کاری هوش مصنوعی به صورت متمرکز پردازش می شود و تنها 5 درصد به صورت Edge پردازش شده است. با این حال، این گزارش بر امکان تغییر عمده تا سال 2028 تأکید میکند، جایی که حجم کاری هوش مصنوعی به طور مساوی تقسیم میشود که در آن 50 درصد به صورت مرکزی و 50 درصد دیگر بصورت Edge پردازش میشوند.

با وجود این چشمانداز در حال تحول، پیشبینی میشود که کل حجم کاری دیتاسنتر ها تا سال 2028 به 90 گیگاوات افزایش یابد، این در حالی است که حجم مصرف دیتاسنتر ها در جهان 54 گیگاوات در سال 2023 تخمین زده شده است یعنی افزایش قابل توجهی که نزدیک به 40 درصد خواهد بود در کمتر از 4 سال و این در حالی است که میزان استفاده و کاربری هوش مصنوعی در جهان در همین سطح باقی بماند و اتفاق غیر منتظره دیگری در مدت این 4 سال نیفتد.

در این مقاله از یو پی اس کاران به نقل از اشنایدر الکتریک، ما به برخی از عواملی که باعث تقاضای انرژی بیشتر در دیتاسنتر ها، به ویژه در زمینه هوش مصنوعی و بار کاری آن میشوند، می پردازیم. علاوه بر این بررسی خواهیم کرد که چگونه پیشرفتهای سخت افزارری، مانند تولید GPU های جدید، بهرغم افزایش بهرهوری باعث افزایش قابل توجهی در مصرف انرژی شدهاند.

میزان مصرف برق در مدل های آموزش و استنتاج هوش مصنوعی

برای آموزش هدفمند و در مقیاس بزرگ مدلهای هوش مصنوعی، باید حجم زیادی از دادهها، سرورهای تخصصی مجهز به شتابدهندههایی مانند پردازندههای گرافیکی و تجهیزات ذخیرهسازی اطلاعات و تجهیزات مختلف شبکه برای قابل انجام شدن تمام این کار ها وجود داشته باشد.

این شتابدهندهها به گونهای طراحی شدهاند که با حداکثر ظرفیت کار کنند، میانگین توان مصرفی یک کلاستر هوش مصنوعی تقریباً برابر با حداکثر مصرف آن است. به عنوان مثال، اشنایدر الکتریک نمونهای از یک کلاستر هوش مصنوعی با 22000 پردازنده گرافیکی H100 که در حدود 700 رک توزیع شده است، ارائه میکند که به 31 مگاوات انرژی نیاز دارد. این برآورد توان شامل توان مورد نیاز برای خنک کردن زیرساخت فیزیکی نمی شود.

در مقابل، قدرت استنتاج هوش مصنوعی و تأثیر آن بر مصرف انرژی بسته به دیدگاه کاربر متفاوت است. شرکتها به دنبال ایجاد تعادل بین دقت خروجی و سرعت هستند، که نیاز به اندازههای مدل و تکنیکهای مختلف استقرار دارد. پیکربندیهای سختافزاری میتوانند به طور گستردهای بر اساس عواملی مانند اندازه مدل و کاربرد متفاوت باشند، از یک دستگاه تک لبه تا چندین رک سرور. چگالی رک می تواند از چند صد وات برای دستگاه های لبه کوچکتر تا بیش از 10 کیلو وات برای سرور های بزرگتر متغیر باشد.

اشنایدر الکتریک نتیجه می گیرد که پیش بینی می شود که بارهای کاری استنتاج کلی نسبت به کلاسترهای آموزشی هوش مصنوعی انرژی بیشتری مصرف کند. این در درجه اول به دلیل مقیاس گسترده ای است که در آن استنتاج هوش مصنوعی به طور مداوم در برنامه های مختلف اعمال می شود. از سوی دیگر، بار کاری در آموزش هوش مصنوعی در رک های با تراکم بالا کار می کنند که شامل پردازش مجموعه داده های گسترده برای آموزش مدل های هوش مصنوعی است. این فرآیند محاسباتی نیازمند مصرف انرژی بالایی در هر رک دارد.

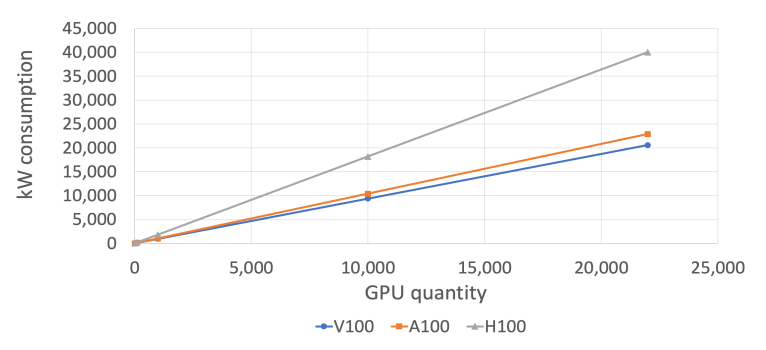

طبق گزارش اشنایدر الکتریک، معرفی نسلهای جدید پردازندههای گرافیکی علیرغم افزایش بهرهوری، منجر به افزایش قابل توجه مصرف انرژی شده است. دیدگاه صنعت در مورد این موضوع این است که افزایش بهره وری بیشتر از افزایش مصرف انرژی است. شکل زیر میزان مصرف انرژی تخمینی در یک دیتاسنتر نمونه را بر اساس تعداد پردازندههای گرافیکی در کلاسترهای آموزش هوش مصنوعی نشان میدهد که شامل سه نسل از پردازندههای گرافیکی است.

برای درک راحت تر موضوع، 40000 کیلووات برق مصرف شده توسط تقریبا 22500 پردازنده مدل GPU H100 می تواند برق حدود 31000 خانه متوسط در ایالات متحده را تامین کند. این موضوع نگرانی رو به رشد در مورد مصرف انرژی با نسلهای جدیدتر GPU ها را برجسته میکند و این چالشها در مدیریت انرژی فراتر از GPU ها، از جمله جنبههای مختلف زیرساخت فیزیکی است. این شکل نشان میدهد که مدلهای GPU V100 در مقایسه با همان مقدار پردازندههای گرافیکی H100، تنها نیمی از توان را مصرف میکنند.

تکنیکهای جدید خنکسازی در دیتاسنترها

اگرچه خنک کردن هوای محیط به طور سنتی روشی برای خنک کردن تجهیزات دیتاسنتر بوده است و می تواند به طور موثر تراکم رک های متوسط تقریباً 20 کیلووات را مدیریت کند، افزایش مصرف انرژی توسط سرورهای هوش مصنوعی اغلب از این آستانه 20 کیلوواتی فراتر می رود. با گسترش کلاستر های هوش مصنوعی و افزایش چگالی مصرف آنها، استفاده از خنک کننده های مایع به یک ضرورت تبدیل شده است.

خنک کننده مایع ظرفیت جذب گرمای بیشتری در واحد حجم ارائه می کند که کارآمدتر از خنک کننده های هوا است. با این حال، توجه به این نکته مهم است که در صورت قطع جریان مایع، دمای تراشه میتواند با سرعت بیشتری در مقایسه با خنککننده هوا افزایش پیدا کند و سبب آسیب سریعتر سیستم در صورت از کار افتادن پمپ مایع خنک کننده می شود که برای کاهش این خطر، استفاده از منابع تغذیه بدون وقفه (UPS) برای پمپ های مایع خنک کننده در دیتاسنتر ها ضروری است.

گزارش اشنایدر الکتریک نشان می دهد که خنک کردن با مایع، کاهش مصرف برق و همچنین مصرف آب را به همراه دارد. این گزارش همچنین استفاده از آب را در سیستم خنک کردن مستقیم تراشه توصیه میکند.

نتیجه گیری

هوش مصنوعی مانند CHAT GPT بعنوان یک ابزار قدرتمند توانست به سرعت در زندگی روزمره جای خود را باز کند، در آمارها آمده است که سرعت جذب کاربر CHAT GPT بیشتر از هر کدام از شبکه های اجتماعی محبوب امروز مثل اینستاگرام و یا یوتیوب بوده است که این نشان دهنده کاربرد وسیع این فن آوری در زندگی همه انسانها در کشور های مختلف و در کسب و کارها است.

این بالا رفتن تقاضا برای پردازش بیشتر اطلاعات و همینطور تقاضا برای گرافیک واضح تر و طبیعی تر در بازی ها و فیلم ها نیازمند پردازش بیشتر و مصرف بیشتر انرژی در جهان است که همانطور که این مقاله اشاره شد، به بررسی این موضوع پرداختیم.